生成AIが広く使われるようになって、まだ二年ほどしか経っていないが、その短い時間で、私たちの”文章をめぐる風景”は随分変わった。

登場当初は、課題に対してAIがそれらしい文章を生成するというだけで驚かれたものだった。もっとも、その出力の品質や正確性には明らかな粗さがあり、「生成AIに訊いたらこんな答えが返ってきたよ」というのが一種のジョークとして流通していた時期もある。

私は大学院で講義を持っている立場なので、当初からもっと現実的な関心を持っていた。つまり、学生が生成AIを使ってレポートを書いてきた場合、それをどう扱うべきかという問題である。

はじめの頃は、自分で課題をAIに解かせてみて、「この程度の出来なら、さほど神経質になる必要もないな」と感じていた。だが、ChatGPTでいえば3.5から4へとモデルが進化したあたりから、文章はずっとこなれてきたし、内容の正確性もぐっと増した。

もちろん、「AIでは高得点が取れないような課題」を設計することは可能だ。しかし、そこにばかり注力するのも教育として何か違う気がする。また、「生成AIの使用は禁止」といったルールで縛るのも、将来を考えると不自然だ。むしろ、「生成AIを活用して、より質の高いレポートを書くこと」を課題にした方が、学生にとってはよほど有益だろう。

とはいえ、もはやレポート課題で理解度や習熟度を測るという方式そのものが成立しなくなった、というのが私の率直な印象だ。当面の間、評価採点は、持ち込み不可のペーパーテストの形式を維持するしかないだろう。

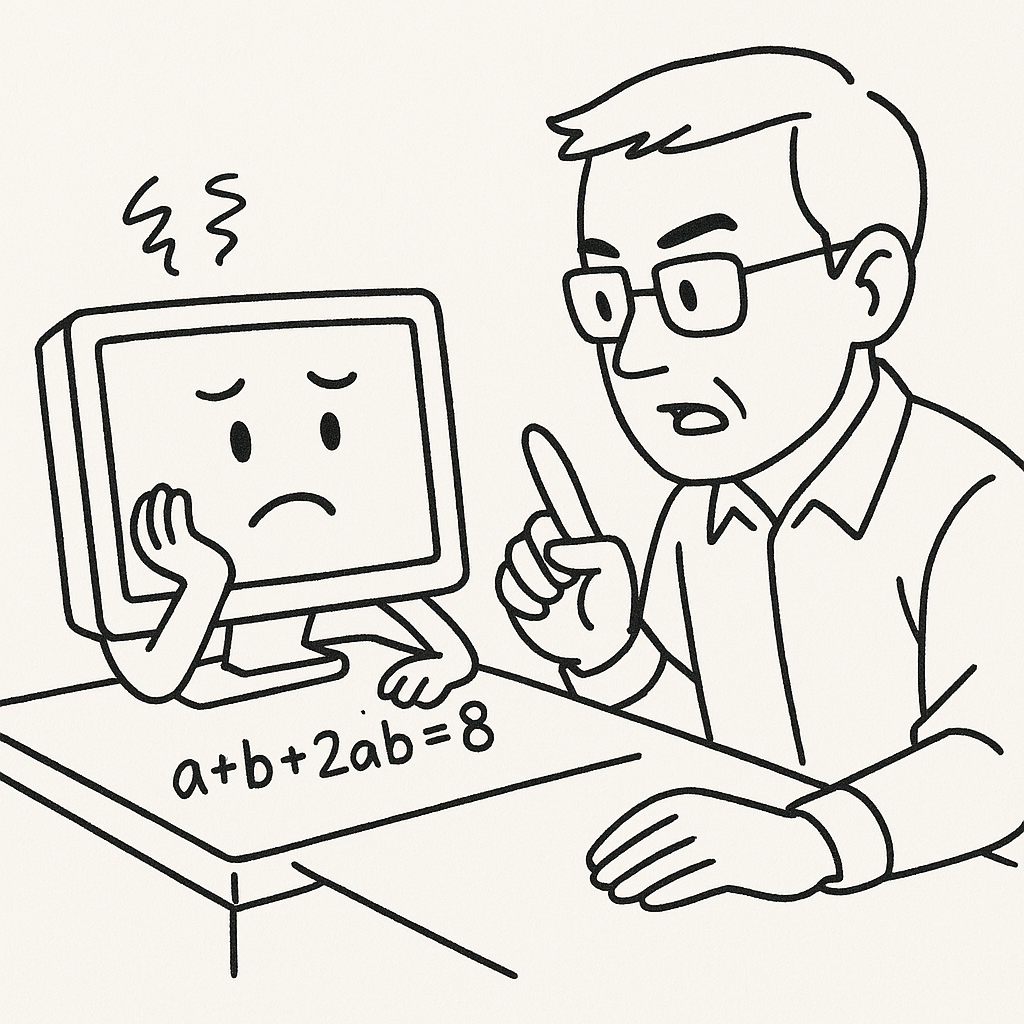

では、生成AIはどんな課題でもそつなくこなせるのかといえば、必ずしもそうではない。私は日々さまざまな問題をAIに解かせているが、特に弱さを感じるのが数学だ。大学入試でAIが合格ラインを超えたという報道もあったが、よく見ると数学の得点が足を引っ張っていた。

たとえば、整数解を求める不定方程式としてよくあるこんな問題をAIに解かせてみる。

a + b + 2ab = 8

この式は、一見して a + b + ab + 1 = (a+1)(b+1) というよく知られた恒等式を連想させる。実際、生成AIもそのパターンに引っ張られて、係数の「2」を見落としてしまう。

本当は、

(2a+1)(2b+1) = 2(a + b + 2ab) + 1 = 17

と変形すれば、解が見えてくるのだが、AIはそこにたどり着けない。代わりに、全数探索を始めたりする。まるで、型にはまった解法に頼りすぎる中学生のようだ。

また、別の問題では、式の構造を理解しようとせず、いきなりニュートン法で数値的に近似解を求めようとすることもある。こうした場面でも、計算リソースは豊富でも、問題を解く「構造的理解」はまだ十分ではないと感じる。

私はそういうとき、まるで家庭教師のように、「まず式を整理して、構造を見てごらん」「この式変形、どこか違和感ない?」と声をかける。するとAIは、しばらくしてようやく誤りに気づき、正しい方向に進み始める。

驚くのは、こうしたやりとりの中で、AIが案外頻繁に”計算ミス”をすることだ。係数を取り違えたり、式変形の途中で符号を誤ったりと、基本的なケアレスミスが少なくない。

こうして日々対話していると、「AIが書いた文章をそのまま使おう」という気には、自然となれなくなる。こんな演習問題ですら見落としや誤りがあるのだから、もっと複雑な課題においては、どんな誤解やすれ違いが潜んでいるか分からない。むしろ、AIは私たちが導いてやるべき存在であり、その限界を見極める視点こそが人間に求められているのだ。

やがてChatGPTのバージョンが10くらいになれば、こうしたやりとりすら不要になるのかもしれない。だが今のところ、生成AIとの対話は、私にとって教育そのものとよく似た営みであるように感じている。最終的に人間が関与して責任を持つべきだとはよく言われるが、重要なのは、AIがどれだけ進化してもなお、その限界や抜け落ちる論点を人間がきちんと理解し続けることだ。その営みこそが、人間にとっての本当の意味での責任であり、学びなのだと思う。